Ogni intelligenza (artificiale e no) richiede un’etica

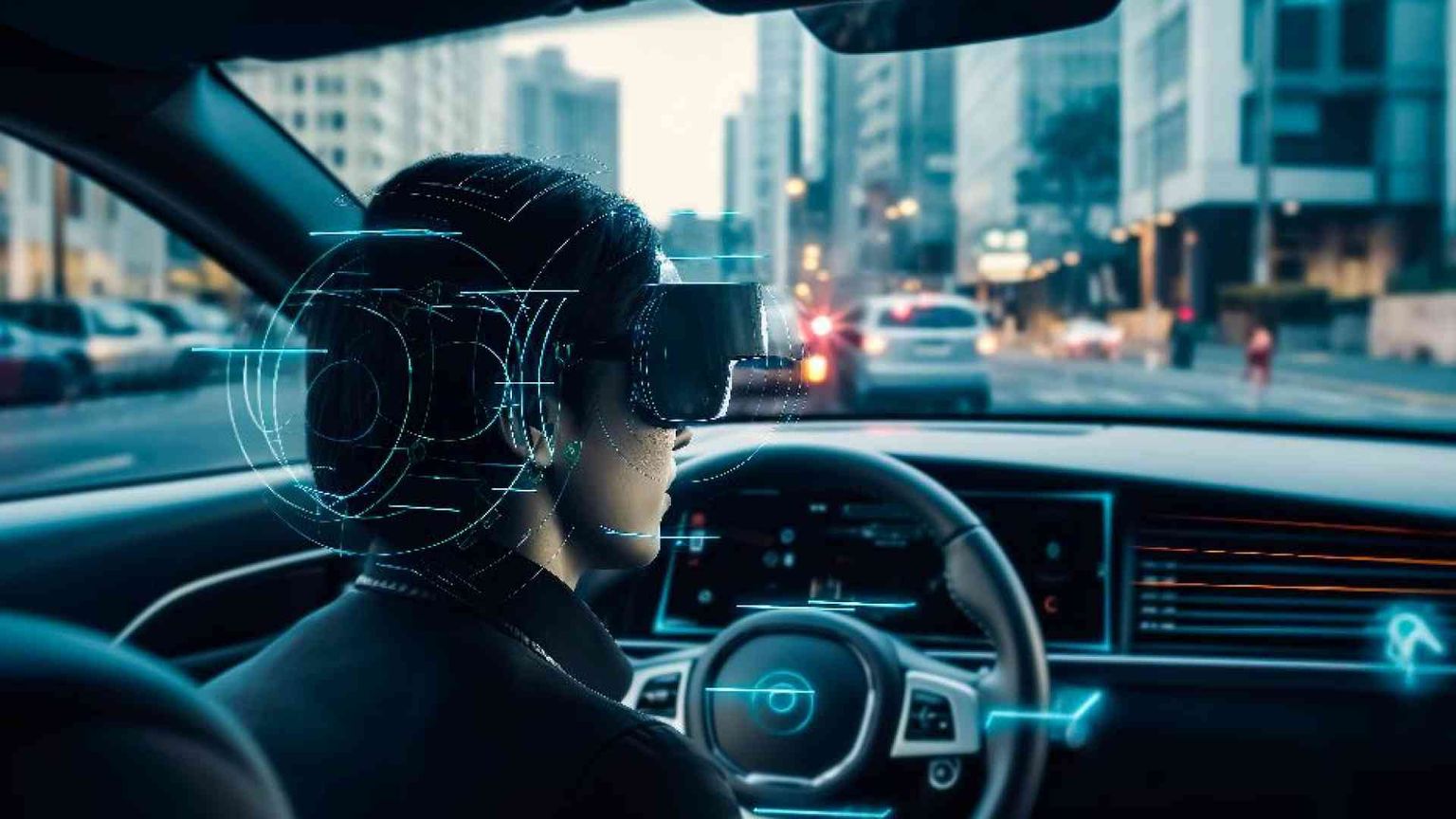

Ai dispositivi l’uomo può dare determinati “valori” cui obbedire (come ai freni dell’auto). Così diventano agenti collocati in armonia in un contesto socio-tecnologico

Le formiche, le api, le gazze ladre, i delfini e i gorilla esibiscono una forma di intelligenza, diversa da quella umana. Essendo consapevoli di esistere sono senzienti e hanno una forma di coscienza, ancora una volta diversa da quella umana. Intelligenza e coscienza sono due qualità della vita biologica che nella specie umana l’evoluzione ha sorprendentemente amplificato e potenziato. Ci può essere coscienza senza intelligenza? Nel saggio Come il cervello crea la nostra coscienza, il neuroscienziato Anil Seth dell’Università del Sussex risponde così: «Potrebbe essere che tutte le entità coscienti siano almeno un poco intelligenti, se l’intelligenza è definita in maniera sufficientemente ampia».

Che le macchine esibiscono un comportamento intelligente è un fatto ampiamente accettato da tempo, ma i recenti progressi dell’intelligenza artificiale hanno stupito persino coloro che la progettano e la realizzano. Assumendo per un solo istante che oltre ad avere un comportamento intelligente le macchine “siano” intelligenti, potremmo chiederci se anche loro hanno una coscienza. Ancora una volta Seth ha una risposta: «Creare computer sempre più intelligenti non equivale a renderli senzienti». La pensa diversamente lo European Innovation Council che nel 2021 ha aperto un bando chiamato “Pathfinder challenge” strutturato in cinque sfide rivolte all’esplorazione di idee forti per tecnologie radicalmente innovative. Una di queste sfide, “Awareness inside” (Consapevolezza interiore), affronta proprio il tema della coscienza delle entità artificiali e del loro rapporto con gli esseri umani.

Ma torniamo alla coscienza e cerchiamo di capirne i due principali significati: consapevolezza di sé e del mondo circostante, capacità di distinguere il bene dal male. Abbiamo già detto che un animale è in grado di collocarsi nell’ambiente in cui vive e di agire con un certo grado di intelligenza. Il suo istinto di sopravvivenza ci porta a pensare che non abbia un sistema di valori, chiamato anche etica, che ne guida il comportamento. Il leone mangia la gazzella senza porsi troppi problemi esistenziali e, allo stesso modo, la gazzella scappa, sapendo che questo è l’unico modo di salvarsi. Discutere con i leoni è tempo perso. È proprio il possesso e l’uso dell’etica a distinguere l’uomo dagli animali. È ciò che ha fatto nascere e sviluppare la società, la cultura, la religione, l’arte, ma anche la guerra. Siamo entità etiche perché siamo intelligenti e non è necessariamente vero il contrario. Anche le macchine stanno evolvendosi e la loro intelligenza (artificiale) sta crescendo in maniera sovrumana.

Emergerà in loro una qualche forma di etica? Per rispondere dobbiamo abbandonare l’approccio fenomenologico e prendere in esame l’intima natura delle macchine. L’intelligenza artificiale si ottiene scrivendo complessi programmi informatici, eseguiti su un’enorme quantità di calcolatori, utilizzando altrettanto enormi quantità di dati. Qualsiasi forma di etica artificiale deve quindi essere codificata nei programmi e nei dati, rispettando rigorose regole formali che richiedono la definizione e la successiva realizzazione di modelli informatici. Rigore, in questo ambito, significa anche rigidità, una qualità che non si addice all’etica. Ne sanno qualcosa i giuristi che stanno provando a formalizzare il diritto, seguendo la strada razionale, ma utopica, indicata da Max Weber e Gottfried Wilhelm von Leibniz.

Da un punto di vista tecnico, quindi, l’etica non è formalizzabile e programmabile e non può essere semplicemente “aggiunta” all’intelligenza artificiale. Questa affermazione, tuttavia, è strettamente vera in senso generale, perché in moltissime macchine è possibile, anzi è obbligatorio, codificare una qualche forma di “etica debole” che rispetta un semplice sistema di valori. Se non fosse così, la nostra automobile potrebbe decidere di non fermarsi, quando freniamo, invocando un artificioso diritto al libero arbitrio. Anche un’etica debole, tuttavia, richiede l’interpretazione del mondo, del contesto sociale al cui interno le macchine agiscono, diventando agenti socio-tecnologici. Le macchine devono agire nel rispetto di pratiche e regole sociali, pur mantenendo la loro natura intrinsecamente informatica. Così facendo acquistano quel significato etico che è proprio degli umani, permettendoci di giudicarne il comportamento sulla base di considerazioni ontologiche.

È un drastico cambio di prospettiva che non richiede più di stabilire se una macchina e la sua intelligenza artificiale siano etiche o no o se siano compromesse da pregiudizi. Le macchine possono essere percepite come dotate di una loro etica, non fine a sé stessa, armonicamente collocate in un sistema socio-tecnologico. In un recente articolo apparso a febbraio sulle Communications of ACM, Deborah G. Johnson e Mario Verdicchio, rispettivamente professoressa emerita all’Università della Virginia e ricercatore all’Università di Bergamo, giungono a queste conclusioni affermando che «tutto ciò richiede molto di più che lavorare con le macchine, anche quelle intelligenti; gli esperti in intelligenza artificiale devono prestare attenzione, ed esaminare criticamente, le caratteristiche del contesto sociale al cui interno intendono progettare le macchine, cercando di migliorarlo». In parole più semplici, l’etica è di chi progetta le macchine affinché i suoi valori siano rispettati quando sono in funzione. L’etica è e deve sempre essere nell’uomo e dell’uomo.

I progetti europei: quanto è cosciente l'Intelligenza artificiale?

Nel 2021, nel contesto del programma Horizon Europe, lo European Innovation Council ha aperto un bando chiamato “Pathfinder challenge” strutturato in cinque sfide, garantendo il supporto all’esplorazione di idee forti per tecnologie radicalmente innovative. Il tema della coscienza delle entità artificiale e della loro interazione con gli esseri umani era al centro di una di queste sfide, “Awareness inside” (Consapevolezza interiore). In particolare, erano richieste proposte di ricerca in grado di definire nuovi concetti di consapevolezza applicabili a sistemi diversi da quelli umani, compresi quelli tecnologici, con implicazioni su come la consapevolezza possa essere riconosciuta o misurata. Oltre a questo, si chiedeva di dimostrare e convalidare il ruolo e il valore aggiunto di un’ampia classe di prodotti e servizi consapevoli per i quali le caratteristiche di consapevolezza possano esibire caratteristiche di qualità sostanzialmente diverse in termini, ad esempio, di prestazioni, flessibilità, affidabilità o esperienza dell’utente. Tra tutte le proposte presentate in risposta al bando ne sono state selezionate e finanziate 39, di cui 8 relative alla sfida sulla coscienza artificiale. Una di queste è relativa al progetto Emerge, guidato da Davide Bacciu del dipartimento di Informatica dell’Università di Pisa, che ha l’obiettivo di studiare come la coscienza emerge spontaneamente in un gruppo di entità artificiali che collaborano per raggiungere determinati obiettivi. La ricerca italiana è presente in altre due proposte approvate. L’Università di Trento partecipa a Sustain, un progetto che si propone di combinare una nuova forma di intelligenza distribuita in un contesto di edificio intelligente, trattato come un organismo cosciente che raggiunge l’autoconsapevolezza tramite i suoi sensori. La Fondazione Istituto italiano di Tecnologia (Genova) partecipa invece al progetto Valaway, un’architettura per la coscienza ispirata al modello Global Neuronal Workspace sviluppato sulla base di prove neurofisiologiche e dati psicologici e un quadro fondamentale per il processo decisionale morale basato sulla psicologia, la cognizione sociale e la scienza sociale del cervello.

Eugenio Raimondi

© RIPRODUZIONE RISERVATA