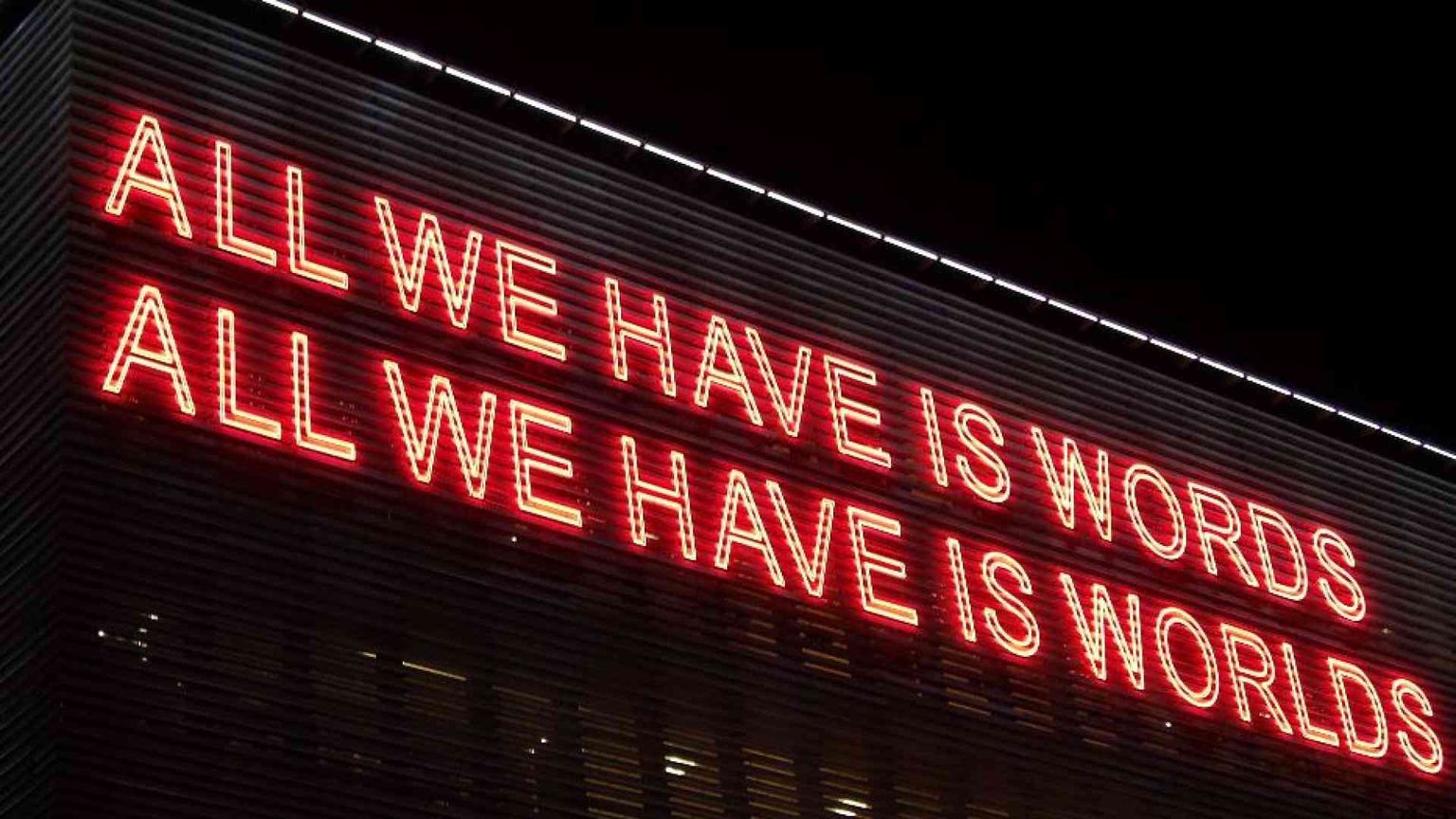

Il potere della parola messo in dubbio dalla Intelligenza Artificiale

La IA non è una fonte affidabile di conoscenza perché rispetto agli umani produce informazioni non verificabili e in modo casuale: ecco perché mette in crisi le basi della società

L’avverbio latino “ibidem” significa “nello stesso tempo e nello stesso luogo”. Quando assistiamo a uno spettacolo teatrale, a un concerto, a un comizio, lo facciamo nello stesso luogo e nello stesso tempo di chi parla, canta o suona davanti a noi. Saremo poi in grado di ricordare l’esperienza come reale e raccontarla ad altri con la certezza della nostra testimonianza diretta. Un’esperienza che può essere condivisa con coloro che non erano presenti, mediante foto, video, resoconti scritti. È lavoro degli storici ricostruire il passato studiandone le tracce documentali. Il valore dei documenti dipende dalla loro autenticità e dalla correttezza dei contenuti. La garanzia di autenticità si basa sull’analisi del supporto (qualità della carta, una volta della pergamena) e sull’attribuzione della paternità. La correttezza dei contenuti è invece una qualità soggettiva, che richiede conoscenza del contesto scientifico, culturale e sociale a cui fa riferimento il documento. Quando le due qualità sono rispettate e riconosciute, il documento diventa una fonte affidabile.

L’intelligenza artificiale generativa, alla base di strumenti come ChatGPT, Gemini e tanti altri, ha messo in discussione il concetto stesso di documento. Niente è cambiato per quanto riguarda il supporto, che è digitale e, come tale, passibile di operazioni di modifica e alterazione difficili da riconoscere. La novità, inattesa e sconvolgente, è la capacità dell’intelligenza artificiale di generare contenuti simili a quelli “umani” in maniera stocastica (ovvero non deterministica e su base probabilistica) a partire da dati di addestramento spesso sconosciuti. A differenza dei contenuti prodotti dagli esseri umani, espressioni culturali ed esperienze di vita reale, quelli generati artificialmente non hanno una chiara e definita identità e paternità ma, soprattutto quando sono usati per raccontare ciò che è accaduto in un luogo e in un tempo remoto, la certezza della loro autenticità viene meno. Nascono le fake news, che stanno avvelenando le reti sociali, il web e i mezzi di comunicazione.

Una visione positivistica della scienza prevede o, meglio, spera che ogni problema potrà essere risolto in un futuro prossimo. Se l’intelligenza artificiale genera contenuti fasulli, ci sarà un modo, una tecnica, per riconoscerli. Purtroppo, la speranza si sta rivelando un’illusione. L’idea di marcare i contenuti artificiali con una “filigrana” (anche chiamata watermark) è di difficile attuazione, perché può essere eliminata, a volte con strumenti molto raffinati. Anche la proposta di raccogliere in un gigantesco archivio i contenuti artificiali, per poi usarli come prova di paternità, si scontra con ostacoli operativi e tecnologici pressoché insormontabili. Infine, l’uso della stessa intelligenza artificiale per l’attribuzione della paternità umana (o artificiale) presenta limiti concettuali e pratici. Dobbiamo quindi prendere atto di un cambiamento epocale, che sta mettendo in discussione uno dei punti fermi della nostra società: la parola. Sono a rischio il racconto delle nostre esperienze, le tracce giuridiche delle nostre decisioni, i dati degli esperimenti scientifici. Il mondo distopico raccontato in 1984 da George Orwell, dove il Grande Fratello cambia a suo piacimento il contenuto dei libri e dei giornali, potrebbe diventare realtà o, a essere più precisi, incubo.

In assenza di efficaci strumenti tecnologici, è pertanto necessario individuare nella società gli antidoti che possano scongiurare questo pericolo. La scuola, a tutti i livelli, deve insegnare l’uso consapevole dell’intelligenza artificiale (e, in particolare, di quella generativa, adesso liberamente disponibile), anziché demonizzarla e proibirla. Deve essere invece sperimentata in classe, sotto il controllo dei docenti, e le parole artificiali devono essere analizzate e studiate. Si deve affermare con chiarezza e semplicità che l’intelligenza artificiale non è una fonte affidabile di sapere e di conoscenza, ma che è soggetta ad allucinazioni che le fanno anche generare contenuti errati o, a volte, totalmente inventati. I media devono parlare diffusamente dei rischi, ma anche dei benefici, della diffusione dell’intelligenza artificiale. Devono farlo in maniera documentata, riportando tempestivamente successi e fallimenti. I politici possono usare l’intelligenza artificiale per produrre contenuti, a patto che siano autentici e corretti, ma non devono generare contenuti falsi e diffamatori a danno dei loro avversari. Il rispetto di questi principi potrà, forse, evitare uno scenario apocalittico in cui le entità artificiali produrranno contenuti che successivamente useranno per il loro stesso addestramento, in un ciclo perverso di autofagia.

© RIPRODUZIONE RISERVATA