Nei robot sempre più umani la pietà non è (ancora) prevista

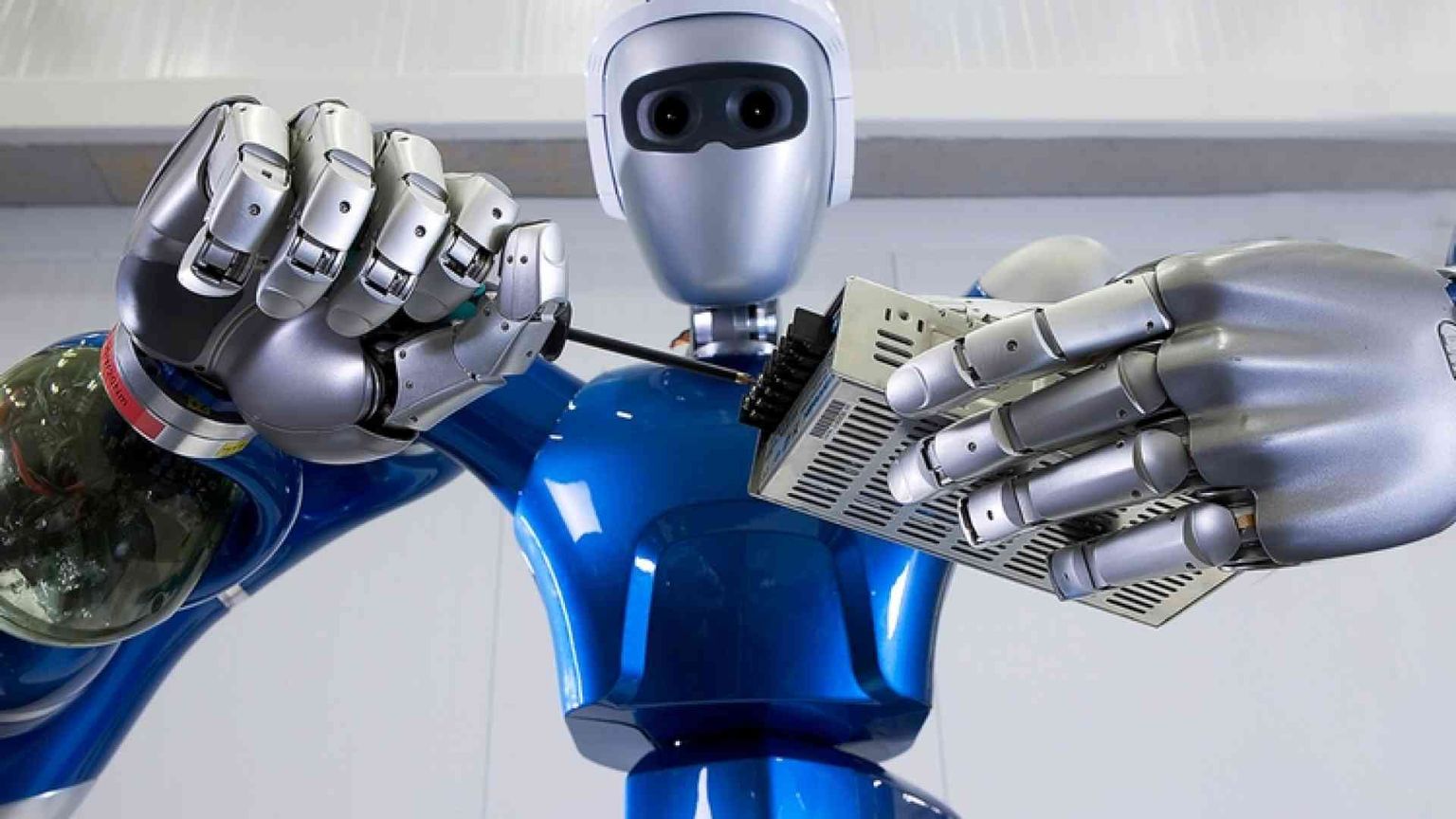

Dunque aveva ragione Isaac Asimov? Davvero dovremo sorvegliare i robot per evitare che si rivoltino contro di noi? Domande non del tutto peregrine, visto lo stupore preoccupato che ha suscitato il prototipo del nuovo robot umanoide, Atlas, appena presentato da Boston Dynamics, azienda in orbita Google. È alto 1,75 metri, pesa un’ottantina di chili, ha gambe, braccia e testa, cammina eretto e si muove come un uomo. Chi l’ha visto all’opera è rimasto ammirato, ma anche perplesso. Per la prima volta, infatti, quello che era un miraggio fantascientifico ha preso forma reale, e non sembra più tanto lontano quel futuro in cui le macchine potranno agire in mezzo a noi con pieno controllo di sé. I problemi cominciano adesso. Contrariamente a ciò che può pensare chi sorride di una paura che sembra ancorata a ipotesi improbabili - la ribellione delle macchine senzienti, alla Terminator -, secondo molti scienziati abbiamo proprio ragione a preoccuparci. Non della ribellione, ma della decisione. Il vero problema delle macchine comincia nel momento in cui compiono azioni che coinvolgono la necessità di scegliere e di decidere. Un vero e proprio problema etico. Spieghiamoci. È già nota la questione legata alle automobili che si guidano da sole (guardacaso, il loro artefice è ancora una volta Google). Non sono ancora al livello di essere sguinzagliate per le nostre strade: le prove finora hanno dimostrato, però, che sono in grado di cavarsela il più delle volte. E nonostante gli incidenti si siano verificati, solo in un caso recente Google ha ammesso un errore nel software. Questo è il punto: quando è in gioco la salute delle persone, 'il più delle volte' non basta. Gli incidenti possono sempre capitare, ma quando al volante c’è un essere umano è più probabile che sappia distinguere un bambino da un barboncino, o che rallenti perché la situazione complessiva lo consiglia. Noi uomini abbiamo un sesto senso, quando guidiamo, che ci avverte di qualcosa che potrebbe andare storto. Il robot-automobile, di sensi, ne ha senz’altro meno di cinque. È un fatto assodato che i computer sono anzitutto dei simulatori. Come sa chiunque usi un pc, simulano benissimo molti strumenti utili all’attività umana: macchine per scrivere, calcolatrici, biblioteche, archivi, enciclopedie eccetera. Se montiamo un computer dentro una macchina utensile, ecco un robot: un qualsiasi macchinario che debba svolgere mansioni sofisticate, riconoscendo le differenze tra le procedure immagazzinate nella sua memoria. Quei robot, adesso, stanno diventando sempre più 'intelligenti'. Le virgolette sono d’obbligo, perché in questo caso il mito dell’'intelligenza artificiale' non c’entra. La procedura è più semplice, ma il risultato è sbalorditivo: se si immagazzina nella memoria del computer una sufficiente quantità di dati, e gli si conferiscono procedure operative adeguate, ecco che diventa in grado di 'scegliere', cioè di confrontare le situazioni con i dati presenti in memoria e agire di conseguenza. È, quindi, una questione di programmazione, perché, ovviamente, le macchine non pensano. Quando il simulatore-computer viene destinato a simulare operazioni delicate che di norma sono svolte da uomini, ci si scontra con una difficoltà insormontabile: anche ammesso che i dati memorizzati siano infiniti e la programmazione precisa e dettagliata, l’unica cosa che il 'cervello elettronico' non potrà simulare è proprio quella intuitiva 'capacità di scelta' che contraddistingue l’essere umano come una creature eidetica e creativa, e che tra due alternative gli fa preferire quella che, volta per volta, reputa la più giusta e opportuna anche in assenza di informazioni già presenti nel suo cervello. Certo, anche gli uomini sbagliano, ma quegli errori di valutazione sono pur sempre errori concepiti da un cervello che corrisponde a un cuore e a una mente. Come ha scritto lo scienziato ungherese Tibor Vámos, specialista in 'sistemi esperti', a volte tra uomini basta un sorriso per fare la differenza cognitiva. E il computer non sa sorridere. Il divulgatore americano Nicholas Carr su questi temi ha scritto un libro piuttosto apocalittico, La gabbia di vetro (l’edizione italiana è di Raffaello Cortina, 2015), in cui propone una serie di esempi in merito, allo scopo di dimostrare quanto siamo lontani da una generazione di robot in grado di simulare il comportamento umano. Un caso tipico coinvolge robot di cui già disponiamo. A pensarci, quell’aggeggio tondo che spazza i pavimenti in molte case, muovendosi autonomamente e individuando da sé percorsi e confini, è piuttosto sofisticato. Inghiotte polvere, ma anche esseri viventi: formiche, per esempio. Nella sua versione da giardino diventa un tosaerba e può imbattersi in rane, pulcini, grilli. Contrariamente a quanto forse faremmo noi, il robot non si ferma. Fa fuori insieme l’erba e l’animale, se è così incauto da non fuggire. Compie, così, un atto eticamente rilevante, del quale in qualche modo chiunque di noi si rende conto: anche quando schiacciamo una zanzara, in qualche modo, le rendiamo omaggio come essere vivente, e se vediamo una coccinella mentre ramazziamo il pavimento di casa, ci fermiamo e facciamo in modo che non venga travolta. Il robot non sa scegliere. Per lui una zanzara e una coccinella non fanno differenza. E quando le travolge, compie ciecamente un atto - se ci pensiamo enorme: noi uomini infatti sappiamo costruire quel robot, ma non siamo affatto in grado di dare vita a un organismo semplice, ma straordinario, com’è quello di una zanzara o di una coccinella. Se affidiamo al robot compiti delicati, dovremmo misurarci con le conseguenze. Un altro esempio di Carr sono i robotsoldato, che a quanto pare sono allo studio degli eserciti in molti Paesi. Costituiscono un orizzonte suggestivo, sia per le prestazioni superiori a quelle di qualsiasi soldato umano, sia perché appunto, potrebbero fare risparmiare a chi li usasse parecchi costi in vite umane. Tuttavia è anche vero che in quel futuro tecnomilitare le vite umane comunque ci sarebbero: soldati nemici, soprattutto civili. Come farà il soldato-robot a distinguere tra un gesto casuale (estrarre un cellulare) e un gesto ostile (sfoderare una pistola)? Soprattutto, come apprenderà il sentimento della pietà che può indurre a risparmiare innocenti o anche nemici ridotti allo stremo? I l soldato-robot, così come l’automobile-robot, il tosaerba-robot e la scopa-robot, potrebbero compiere scelte esiziali per vite non robotiche. Certo, le conseguenze morali in definitiva ricadono sull’uomo, che è pur sempre l’inventore e il mandante. Tuttavia preoccupa constatare che esista la tendenza a infischiarsene. Come ha lucidamente spiegato Günther Anders, il ventesimo secolo ha inaugurato l’era dell’irresponsabilità: dalla prima bomba atomica sganciata su Hiroshima a questa parte, ha preso campo quella 'filosofia della discrepanza' che documenta il divario tra quanto è tecnicamente possibile e le sue conseguenze etiche. L’uomo è 'antiquato', sosteneva Anders, cioè commette azioni collettive di cui, come individuo, non riesce a sentirsi responsabile. Eppure quelle azioni avvengono. Chi ha sterminato i cittadini di Hiroshima? Il presidente Truman? L’uomo che pilotava il bombardiere? Quello che ha premuto il pulsante di sgancio? Gli scienziati che hanno concepito la bomba che si sarebbe chiamata Little Boy? I tecnici che l’hanno costruita? Domande che trovano una nuova attualità. Chi è responsabile delle azioni dei robot? Nel nascondino delle responsabilità restiamo esposti ad azioni oggettivamente atroci, seppure condotte freddamente da una 'mente simulata'. Isaac Asimov, che aveva competenze scientifiche ed era un ottimo scrittore, è riuscito a immaginare tutto questo quando dei robot non c’era neanche l’ombra, e nei suoi mondi romanzeschi aveva stabilito le tre 'Leggi della robotica'. La prima proibiva di arrecare danno agli esseri umani. È un impegno che potremo mantenere anche nei nuovi mondi che stiamo costruendo?

© RIPRODUZIONE RISERVATA