Gran Bretagna, se l’algoritmo è discriminatorio

Dalle formule errate a quelle che cercano di catalogare le persone sulla base dell’etnia o del luogo di provenienza: un problema anche per la democrazia

La rivolta degli studenti britannici contro la decisione del governo di affidare a un algoritmo l’esito degli esami di maturità che non si sono potuti svolgere in presenza a causa del coronavirus ha il sapore antico della satira settecentesca. Nello slogan “ditch the algorithm” (sbarazzati dell’algoritmo) gridato il 16 agosto in piazza del Parlamento, a Londra, riecheggia la rimostranza con cui, nel 1726, lo scrittore inglese Jonathan Swift denunciava ne “I viaggi di Gulliver” l’ottusità matematica dei filosofi naturali dell’epoca, intenti a contemplare la perfezione geometrica dell’isola volante di Laputa - dove il pane veniva tagliato in coni, cilindri e parallelepipedi - piuttosto che a occuparsi della vita reale.

Nessun altro paese al mondo, tra quelli che a causa della pandemia hanno dovuto rivedere le modalità degli esami di maturità, ha pensato, come ha fatto il governo di Boris Johnson, di ricorrere a un algoritmo per decidere il voto con cui “licenziare” milioni di studenti. La decisione è maturata ai piani alti del ministero dell’Istruzione, guidato dall’ex capogruppo Tory ai Comuni, Gavin Williamson, che ha incaricato l’Ofqual, agenzia governativa che regola a livello nazionale qualsiasi procedimento per attestati e qualifiche, di dirimere la faccenda utilizzando il gelido approccio della statistica applicata. Per settimane, i tecnici si sono cimentati nello studio di 11 diversi modelli, poi ne hanno scelto uno che stabiliva il voto finale combinando, tra le tante variabili, le performance ottenute da ogni singolo studente negli anni precedenti e il rendimento accademico ottenuto a lungo termine da ogni singola scuola.

Nessuna equazione è stata introdotta a mitigare la gelida razionalità dei risultati con fattori più “volatili” come dedizione, impegno, determinazione. L’aspetto più controverso dell’algoritmo che ha rischiato di far saltare la testa di Williamson – ma che ha portato Johnson a chiedere scusa e spinto alle dimissioni Sally Collier, capo dell’Ofqual – è stato il peso dato dalla formula alle caratteristiche delle scuole di provenienza degli esaminandi: pubbliche o private, ricche o povere, di centro o periferia. Il pregiudizio che ha viziato i calcoli, insomma, è stato quello secondo cui il rendimento degli istituti privati, elitari e costosissimi, è tendenzialmente più alto rispetto a quello degli statali. È scoppiato il finimondo. La percentuale di studenti ad aver ottenuto un voto più basso rispetto alle iniziali valutazioni degli insegnanti è stata del 40%. Giovani a cui, di conseguenza, veniva preclusa la possibilità di ammissione a università di prestigio, ac- cessibili solo con il massimo dei voti, come quella di Oxford o Cambridge. La protesta è stata tale da costringere il ministero ad annullare la valutazione e, nell’imbarazzo generale, a rifare i giudizi, questa volta affidandoli esclusivamente ai docenti.

Il pasticcio, certo, si è concluso con un lieto fine: chi meritava di entrare nei campus d’élite, ricco o povero che sia, ha avuto la sua occasione. Le reazioni che la vicenda ha scatenato nell’opinione pubblica sono però valse a innescare una riflessione profonda sull’uso spesso improprio e spregiudicato della statistica. A distanza di giorni dall’accaduto, i britannici continuano a chiedersi come è possibile che il governo abbia scelto, tra tanti, proprio quell’algoritmo per valutare una generazione di studenti. Il problema, osserva qualcuno, non è tanto lo strumento in sé, ma il modo in cui è stato intenzionalmente programmato. Tom Haines, dell’Università di Bath, ha spiegato alla BBC di aver letto il materiale con cui Ofqual ha illustrato il design dell’algoritmo e di aver notato che, a prescindere dagli «errori tecnici », incredibilmente, «è stato scelto proprio il modello più fraudolento».

Gli algoritmi, di per sé, non sono un male. Hanno origine antichissime se si pensa che uno dei primi esempi, come quello per il calcolo dei numeri primi, risale al matematico dell’Antica Grecia, Eratostene di Cirene. Oggi, trovano applicazione in numerosissimi ambiti della vita quotidiana: un algoritmo quantifica, giusto per citarne qualcuno, l’importo delle polizze assicurative, calcola l’incidenza delle malattie sulla popolazione orientando le politiche di prevenzione, indirizzano la pubblicità online a seconda dei “like” espressi dagli utenti sui social network. Il punto, insomma, è che sono utili ma vanno maneggiati con cautela. Il rischio più grande, quello che il pasticcio di Williamson ha chiaramente messo a fuoco, è che possono amplificare e propagare eventuali errori, pregiudizi o distorsioni a monte del sistema in cui vengono sviluppati.

L’annullamento degli esiti dei test e le scuse di Johnson dopo che è emerso che i voti risentivano anche delle caratteristiche delle scuole di provenienza: pubbliche o private, ricche o povere, di centro o periferia .Sotto accusa ci sono anche i software per il riconoscimento facciale della polizia e i programmi per valutare le richieste d’asilo

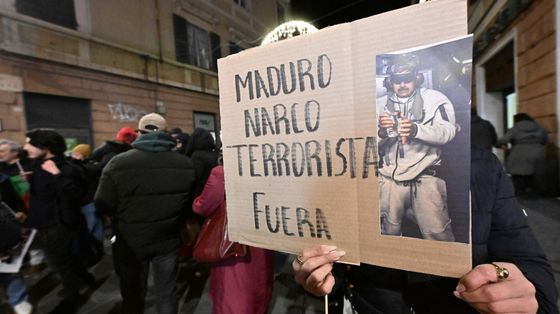

Ne è un esempio il caso sollevato all’inizio dell’anno dal think tank RUSI con la pubblicazione di un rapporto sulle attività di polizia orientate dagli algoritmi. Secondo gli esperti, alcuni software come quelli per il riconoscimento facciale o per la proiezione di mappe del crimine si fondano su dati viziati da pregiudizi sociali o razziali. Quante possibilità ha un abitante di Croydon, uno dei quartieri più a rischio della capitale britannica, di dimostrare la sua presunzione d’innocenza in caso di accoltellamento? Pochissime, secondo la matematica. Soltanto qualche giorno fa, ancora, il ministero degli Interni britannico ha mandato in soffitta dopo una vivace battaglia legale una formula adottata dal 2015 per valutare le richieste di visto nel Regno Unito. Secondo l’associazione Foxglove, che per prima ha sfidato il governo in un contenzioso riguardante l’intelligenza artificiale, il sistema escludeva in automatico alcune nazionalità preferendone invece altre. «Abbiamo bisogno di democrazia, non di policy basate su algoritmi segreti – ha commentato Cori Crider, direttore della Ong – chiedete al pubblico se un sistema di automazione è appropriato o no, rendetelo trasparente cosicché i pregiudizi possano essere estirpati».

Il governo attualmente in carica nel Regno Unito sembra ossessionato da numeri, dati e progetti di intelligenza artificiale. La tentazione all’utilitarismo tecnologico alla Jeremy Bentham sembra essere tornata in voga, in particolare, con il braccio destro di Johnson a Downing Street, Dominc Cumming che, dopo aver impiegato gli algoritmi per vincere il referendum sulla Brexit, ha premuto per una rapida espansione delle applicazioni di IA in ogni dipartimento di Whitehall. Tra le spese sostenute per affrontare la pandemia ci sono 400mila sterline investite in algoritmi per monitorare la risposta del pubblico al virus. Standardizzare, misurare, aggregare: questo è l’approccio alla “governance scientifica” che permea oggi le politiche pubbliche britanniche. Lo ha sottolineato anche il settimanale The Economist spiegando che questa tendenza, gelida e talvolta miope, è stata in parte resa possibile dalla graduale perdita di potere dei sindacati.

Il ministro Williamson era così preso dalla necessità di non inflazionare i voti che avrebbero dato accesso al mondo esclusivo delle Università britanniche che non ha neppure considerato un’alternativa all’algoritmo per risolvere il problema. Tra le strade percorribili c’era, fanno notare gli esperti, la semplice ricerca di una mediazione con gli atenei per individuare criteri di ammissione rivisti in base alla straordinarietà del momento. Ipotesi di buon senso, si direbbe, mai contemplata. Oltre a rivelare una certa noncuranza nei confronti di quello che, di per sé, la maturità rappresenta per gli studenti quello che il governo britannico ha messo in scena, per usare la sintesi di Hye Jung Han, ricercatrice dell’associazione Human Rights Watch ripresa da un articolo del Mit Techonology Review, è stato uno «spettacolare fallimento dell’immaginazione». Ma, si sa, sull’isola volante di Laputa, quella che i britannici sembra stiano ancora ad ammirare con il naso all’insù, le parole “fantasia” e “creatività” non esistono neppure.

© RIPRODUZIONE RISERVATA