Perplexity pagherà i giornali per i loro articoli. Basterà?

Un nuovo accordo economico siglato tra i Wall Street Journal e il New York Times con la startup di intelligenza artificiale riapre il dibattito sull'uso dei contenuti da parte dei chatbot

Se l’intelligenza artificiale sa rispondere alle domande degli utenti e fornire una panoramica riguardo a qualsiasi ramo dello scibile umano, il merito è dell’algoritmo progettato dal fiore degli ingegneri informatici ma anche dei contenuti che gli sono dati in pasto. Tra cui ci sono anche miliardi di pagine compilate da ignari scrittori e giornalisti.

Perciò da anni i gruppi editoriali stanno chiedendo a colossi tecnologici come OpenAI, Google, Microsoft, Amazon e Apple – genitori di ChatGPT, Gemini, CoPilot e rispettive alternative – di pagare il loro lavoro.

Lo hanno fatto – e ottenuto – ieri il Wall Street Journal e il New York Times con Perplexity, motore di ricerca artificiale e principale rivale di OpenAI. I quotidiani americani insieme al giapponese Yomiuri Shimbun hanno fatto prevalere la propria visione su quella dell’azienda che d’ora in avanti dovrà pagare le testate quando i loro contenuti verranno utilizzati dal browser di ricerca di Perplexity o dall’assistente intelligente per rispondere a domande e richieste.

La decisione arriva al termine di una contestazione intentata dai gruppi editoriali e che ora Perplexity sembra chiudere prima che vengano aperte vere e proprie azioni legali: la startup di San Francisco avrebbe già accantonato 42 milioni e mezzo di dollari per creare un motore di ricerca specifico, chiamato Comet Plus, e alimentato con i contenuti dei giornali, ai quali spetterà l’80 per cento dei ricavi degli abbonamenti di chi usufruirà del servizio (a pagamento).

La notizia non è la prima del genere e riapre una lunga diatriba in corso tra gruppi editoriali e tecnologici fin dalla prim’ora dell’avvento delle tecnologie generative,

In generale l’uso dei contenuti giornalistici e coperti da copyright è vietato ai sistemi di intelligenza artificiale. Per tutelarsi diversi gruppi editoriali o semplici pagine web inseriscono un file nel codice del loro sito per cercare di impedire ai bot e agli strumenti automatizzati di estrarre dati in massa per le proprie intelligenze artificiale. Non sempre, però, i bot, e le aziende che li manipolano, rispettano queste indicazioni e aggirano la normativa. Poche settimane fa, proprio per questa ragione, la Bbc ha intrapreso un’azione legale contro Perplexity scoperta a saccheggiare i suoi contenuti, nonostante i limiti e in barba alle regole di diritto d'autore britannico. La stessa cosa hanno fatto nei giorni scorsi due dei più prestigiosi gruppi media giapponesi (che controllano, però, anche il Financial Times) depositando una pesante causa al Tribunale di Tokyo che chiede a Perplexity un risarcimento di 2,2 miliardi di yen e l'eliminazione dei contenuti archiviati senza autorizzazione.

Eppure, visto che tutelarsi sembra molto difficile, molti editori hanno fatto una scelta diversa e raggiunto accordi economici singoli con i diversi colossi di Ia con cui coprono sia i contenuti già usati per l’addestramento dei Large language model sia quelli prodotti quotidianamente. Il New York Times, ad esempio, ha concesso in licenza i propri articoli ad Amazon per l'addestramento delle sue piattaforme AI; il gruppo News Corp, editore tra gli altri del Wall Street Journal e del New York Post, si è accordato per ricevere da OpenAI 250 milioni di dollari in cinque anni e ha diffidato Perplexity per uso improprio dei propri contenuti; mentre l’editore tedesco Axel Springer, dietro alla Bild e Politico, dovrebbe ricevere tra i 25 e i 30 milioni nell’arco di tre anni. Secondo quanto si sa, il Financial Times dovrebbe invece ottenere tra i 5 e i 10 milioni all’anno. E simili accordi sono stati presi da Vox Media, Le Monde, la spagnola Prisa Media e l’italiana Gedi.

La soluzione fa senz’altro gola agli editori, con sempre meno fondi a disposizione, ma rischia di essere una mancetta una tantum per le aziende tecnologiche che, da un lato, sembrano non arrestare il numero dei loro clienti e dall’altro non hanno ancora raggiunto la maturità aziendale per garantire continuità a questi pagamenti che, a un certo punto, potrebbero lasciare a bocca asciutta gli autori delle pubblicazioni.

Non solo. Pur in presenza di accordi, il fatto che i contenuti dei quotidiani passino attraverso la mediazione dei chatbot può danneggiare le testate che saranno sempre meno identificabili e offuscate – anche visivamente – dallo standard imposto dall’intelligenza artificiale di turno. La conoscenza già minima che il pubblico ha dei giornali potrebbe dunque diminuire ulteriormente e compromettere il rapporto di fidelizzazione e fiducia con i lettori necessario per attirare abbonamenti e investimenti pubblicitari.

E poi c’è la questione dei piccoli. Per siti web e testate di nicchia si pone il dilemma: opporsi ai chatbot in una lotta impari alla Davide e Golia; oppure sfruttare la visibilità che questi strumenti potrebbero dare ai loro contenuti per fare qualche clic in più? Per ora ognuno risponde in ordine sparso anche se – a quanto sembra – le fonti a cui attingono i modelli di intelligenza artificiale sono i contenuti già più indicizzati online e solo in misura residuale viene selezionata parte del restante mare magnum di Internet: un meccanismo che per i piccoli è penalizzante e crea un circolo vizioso da cui è difficile uscire.

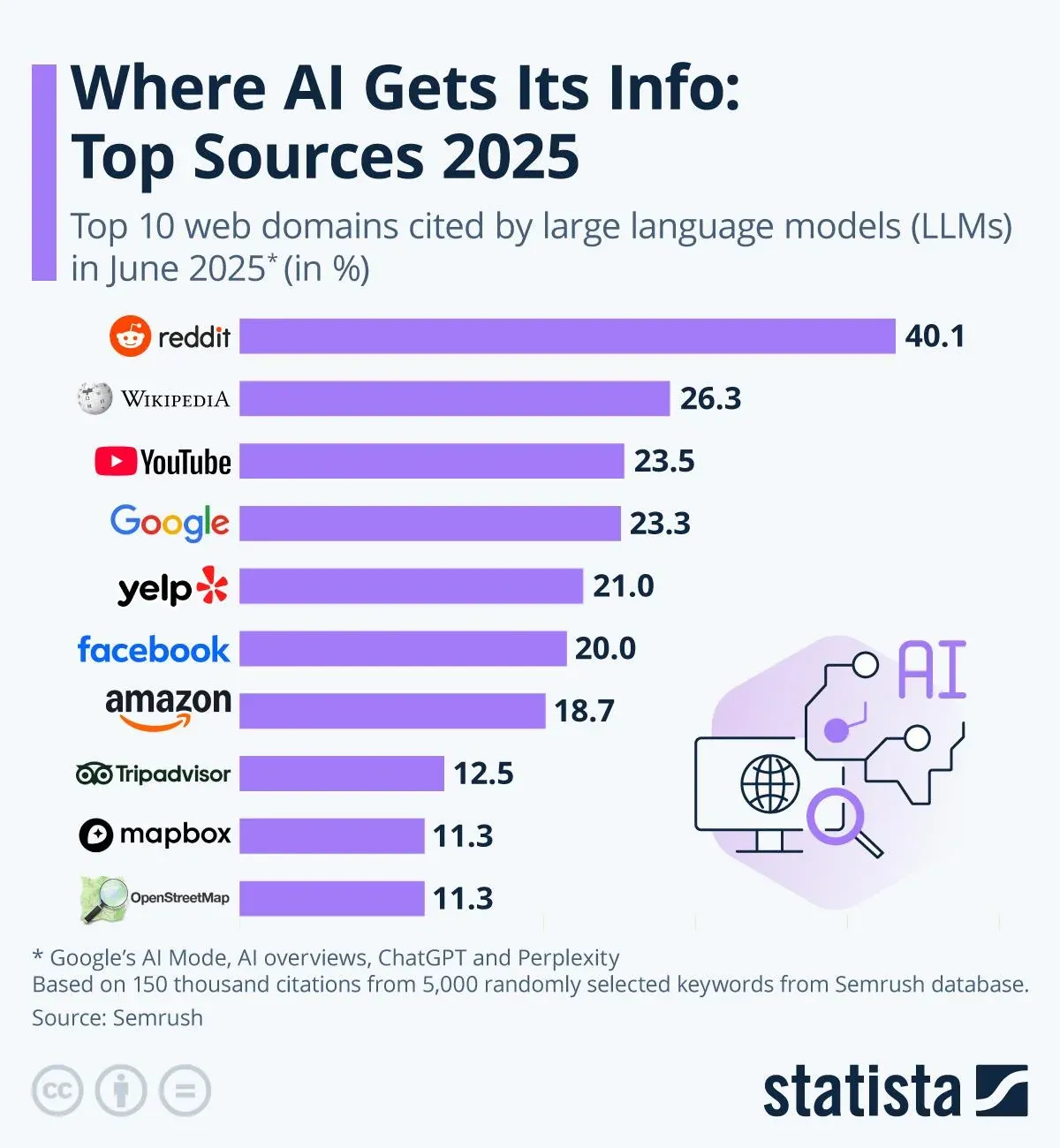

La qualità dei contenuti prelevati dall’intelligenza artificiale è stata osservata a giugno da Semrush, società che analizza le prestazioni delle varie pagine web, e che ha anche compilato una classifica sui domini più citati dall’intelligenza artificiale. In termini di quantità i Large language model sembrano attingere soprattutto a Reddit, un celebre forum in cui da decenni gli utenti discutono di qualsiasi argomento, con una frequenza di citazione del 40,1 per cento; per il 26,3 per cento si appoggiano a Wikipedia e soltanto a seguire a YouTube, Google e Yelp.

Si tratta di domini aperti o open source che non espongono le società tecnologiche a questioni legali e che però offrono conoscenze generate dagli utenti, di cui non si può certificare l’accuratezza né l’imparzialità e che possono diventare pericolosi soprattutto su argomenti delicati come salute, diritto o finanza.

La mancata regolamentazione, anche a livello di copyright, dell'intelligenza artificiale fa comodo a chi vive di questa tecnologia. È di ieri la notizia, riferita da Politico, che Meta – attraverso un comitato ad hoc – si appresta a finanziare i politici favorevoli a deregolamentare l’intelligenza artificiale con decine di milioni di dollari con l’obiettivo di avere una classe dirigente compiacente alle proprie istanze. Tra cui figurano anche regole il più possibile lasse sul trattamento delle informazioni d’autore.

© RIPRODUZIONE RISERVATA